说起AI大语言模型,相信熟悉的人都会立刻联想到性能强大的通用CPU处理器、专用GPU加速器,只有它们才能提供足够的算力进行训练不过在推理应用方面,算力需求就没有那么高了,再加上厂商们在软硬件和开发工具上的不断优化,一台轻薄的笔记本如今也能轻松胜任大量AI工作,AI PC的时代正在逐渐到了。

比如Intel,如今的12/13代酷睿处理器、锐炫A系列显卡,以及即将发布的全新酷睿Ultra处理器,都有足够的算力满足生成式AI(AIGC)的需求再加上Intel的软件生态、模型优化,可以快速推动AIGC场景在PC上的落地,包括轻薄本、创作本、全能本、游戏本、台式机等多种形态。

特别是通过模型优化,Intel大大降低了对硬件资源的需求,进而提升推理速度,使得社区开源模型可以很好地运行在PC上以大语言模型为例,Intel通过13代酷睿处理器XPU加速、低比特(low-bit)量化,结合其他软件层面优化,通过BigDL-LLM框架,就可以运行在16GB及以上内存的PC上运行最高160亿参数。

已经验证过的模型包括但不限于:LLAMA/LLAMA2、ChatGLM/ChatGLM2、MPT、Falcon、MOSS、Baichuan、QWen、Dolly、RedPajama、StarCoder、Whisper等等。

此外,Intel还提供了Transformers、LangChain等易用的API接口,并支持Windows、Linux操作系统。

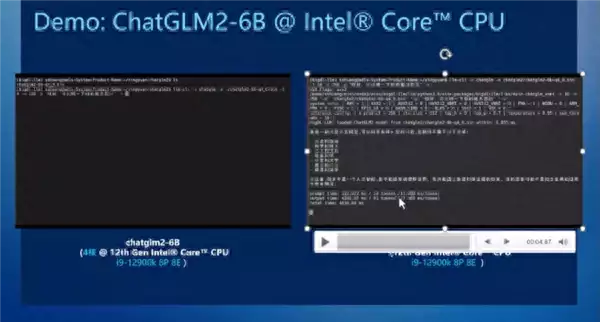

比如,Intel正在打造的开源框架BigDL-LLM,专门针对Intel硬件的低比特量化设计,支持INT3、INT4、INT5、INT8等各种低比特数据精度,性能更好,内存占用更少它在i9-12900K处理器上就可以达成飞快的运行速度,输出性能达到了每个Token 47毫秒左右,已经不弱于很多云侧计算。

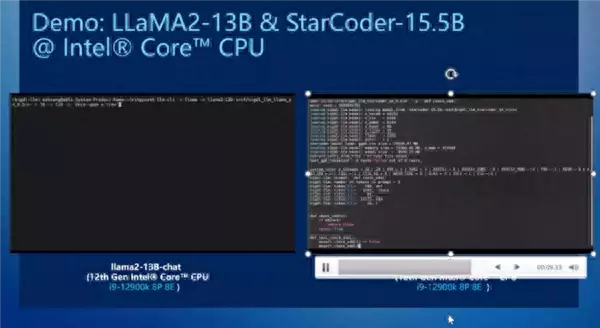

在LLaMA2 130亿参数大语言模型、StarCoder 155亿参数代码大模型上,Intel酷睿处理器也都能获得良好的运行速度。

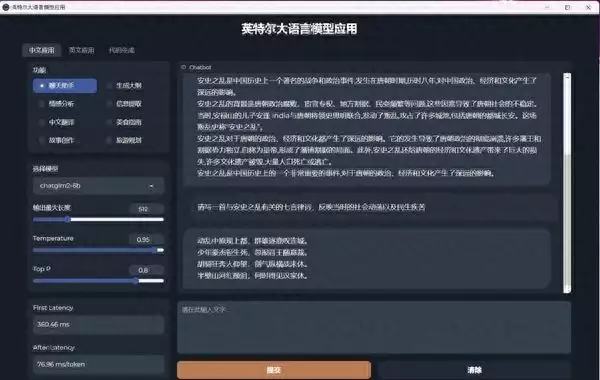

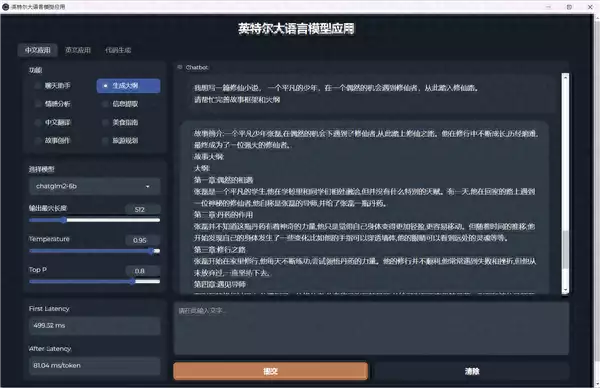

Intel还设计了一个大语言模型DEMO,集成ChatGLM2、LLaMA2、StarCoder,通过优化和量化操作,在任何基于12/13代酷睿的PC上都可以快速生成想要的结果,哪怕是轻薄本这个DEMO可以选择不同的大语言模型、设定不同的参数,。

支持中文应用、英文应用、代码生成三大方面,其中中文应用就包括聊天助手、情感分析、中文翻译、故事创作、生成大纲、信息提取、美食指南、旅游规划等八个方面,覆盖日常生活、工作的方方面面。

此外,Intel还积极拥抱AI社区,基于OpenVINO PyTorch后端方案,通过Pytorch API,使得社区开源模型可以很好地运行在Intel的消费级处理器、集成显卡、独立显卡、专用AI引擎之上。

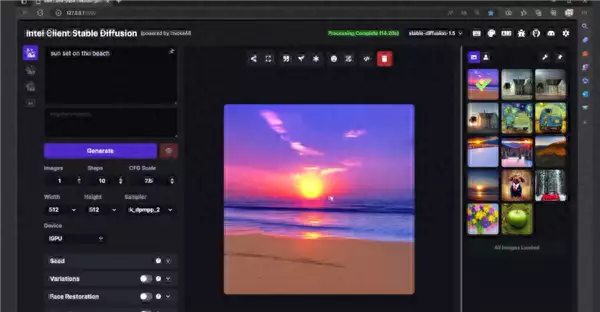

比如图形视觉领域最火的Stable Diffusion的实现Automatic1111 WebUI,已经可以在Intel处理器、显卡上以FP16的浮点精度运行,包括文生图、图生图、局部修复等都可以获得良好的体验。

哪怕是使用Arc A730M这样的入门级笔记本显卡,都可以在几秒钟内完成高质量的文生图、图生图、图像风格转换等,从而极大地节省工作量,让设计师将更多精力放在创意上这足以证明,在Intel软硬件的联合调校之下,一台普通的笔记本在端侧运行大模型,依然可以获得足够快的响应速度和良好的体验。

相信随着全行业的不断努力,PC端侧的AI应用会越来越广泛、高效,让更多人随时随地享受AI带来的变革性体验。

亲爱的读者们,感谢您花时间阅读本文。如果您对本文有任何疑问或建议,请随时联系我。我非常乐意与您交流。

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。